هذا المقال بقلم نيكوليتا لاكوباتش مستشارة في جامعة "سينغيولاريتي" بكاليفورنيا والمشرفة الرئيسية على "تيد أكس ترانزميديا" والآراء الواردة أدناه لا تعبر بالضرورة عن رأي شبكة CNN.

لا داعي لأن نبحث كثيراً لندرك أن الخيال العلمي أصبح الآن حقيقة علمية. فنحن نعيش في زمن السيارات الطائرة، وطباعة الأعضاء البشرية بتقنية ثلاثية الأبعاد، والتعديل الجيني. هذه ليست الا بعض الأمثلة التي باتت ممكنة الآن. فالتكنولوجيا لا تنتظر أحد وتنمو بشكل متسارع. ويومياً، يتحوّل المستحيل ممكناً، فنشهد تقنيات جديدة تغيّر، بشكل كبير، حياتنا اليومية.

إلا أن الأخلاقيات البشرية لا زالت تواجه صعوبة في مواكبة ركب التكنولوجيا المتغير؛ فالتكنولوجيا لا تنتظر أن يلحق بها ركب الأخلاقيات لأنها آخذة في التقدم بصورة مضطردة، مما يتسبب في ارتفاع حدة النقاش الأخلاقي ويؤدي إلى الكثير من المشاكل المعتبرة.

تتمحور المشكلة في هذه النقطة بالتحديد: أصبح من الصعب، أكثر من أي وقت مضى، التعرف على الآثار والعواقب والمضاعفات المحتملة عن نقلة نوعية في مجال الابتكارات الخاصة التي نقوم بها، بل حتى وضع تعريف مقبول لها.

يرى كل من يولي اهتماماً بالأمر أننا نعيش فترة من التقدم بسرعة البرق في القرن الواحد والعشرين، وأننا سنشهد أنّ ما يحتاج إلى آلاف السنين من التقدم يصبح حقيقة في بضع عقود قليلة. لا شك إذن أن الذكاء الآلي سيفوق الذكاء البشري، إن لم يكن في زمننا هذا، فمن المؤكد أن ذلك سيحدث في هذا القرن بالذات.

قد يهمك أيضا.. رجل آلي قد يحقق أحلام الأطفال المجبرين على البقاء في المستشفى أو ملازمة الفراش

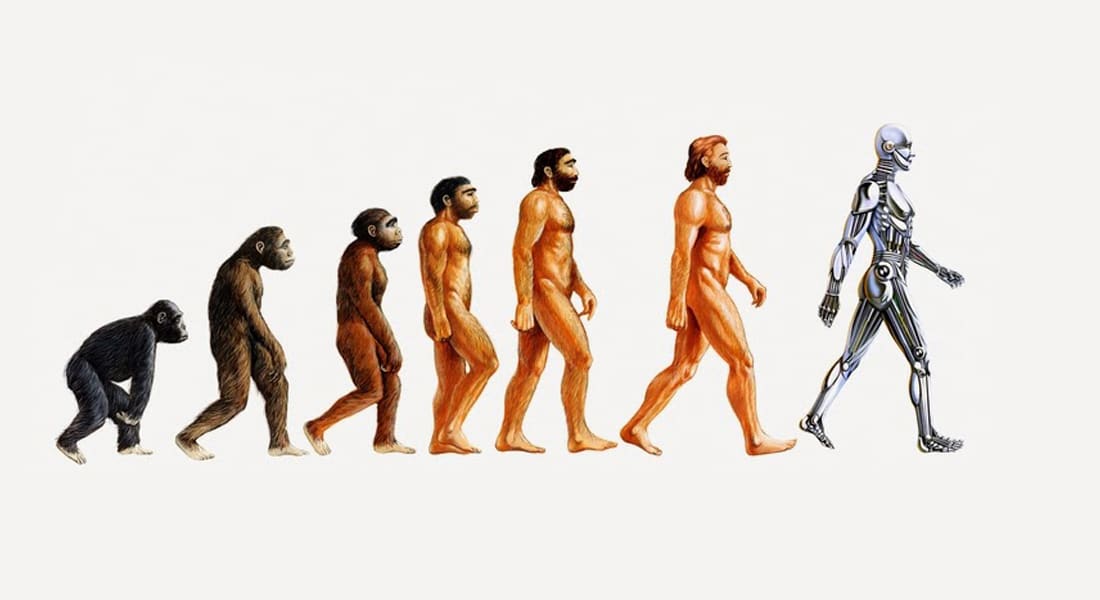

سنبدأ برؤية تغيرات تكنولوجية لم نشهدها من قبل، سواء كان ذلك على صورة الدمج بين العناصر البيولوجية وغير البيولوجية، أو ولادة الإنسان المبرمج الذي لا يموت، أو نشأة الذكاء الاصطناعي ذي المشاعر والأحاسيس.

كل هذه الابتكارات تحمل إمكانية تعزيز قدرات البشر الإدراكية؛ فبإمكانها دعم الاقتصاد والمساعدة في بناء اقتصادات أخرى، لا بل إطلاق تقنيات أكثر قوة. وبالتالي، تعتبر ردة فعلنا بغاية الأهمية.

لا بد لنا من التركيز على المسؤولية والأخلاقيات الخاصة بسلوك الآلات. ولكن، ماذا عن مسؤولية أخصائيي التكنولوجيا الذين يصممون هذه الابتكارات في الوقت الحالي؟

هناك مشاريع تسعى إلى تطوير أنظمة روبوتية تتمتع بالحكم الذاتي ومبرمجة لتعرف الفرق بين الصح والخطأ ولتقييم التبعات الأخلاقية. ولكن، لا زال هناك سؤال مهم يحتاج إلى إجابة.

كيف سيتمكّن الروبوت بالتفكير الأخلاقي أو المعنوي فيما غالباً ما يعجز مخترعوه عن ذلك؟

كذلك.. بالفيديو: تقنيات هوليودية تساعد هذه الطفلة على المشي

كثيرة هي الأسئلة الأخلاقية التي تُطرح. فإذا أصبحت الآلات فائقة الذكاء (روبوت متطور يفوق ذكاؤه ذكاءنا، على سبيل المثال) قادرة على الإحساس – أي، أصبحت قادرة على التأمل والشعور – هل يجب علينا أن نعاملها كبشر؟ هل علينا احترام مشاعرها، أم أنه سيبرز بُعدٌ جديد وتعريف آخر لمن هو "بشر"؟

فيما يتعلق بالكرامة الإنسانية، والأخلاقيات، والاستقلالية: هل ستبقى هذه المدركات على حالها؟ هل يجب أن تلعب الأخلاقيات دوراً فيها؟ إذا كان الجواب "نعم"، فـ "كيف؟.

الأخلاقيات هو مصطلح يوناني قديم. وكان أرسطو أول من استخدمه ليعكس محاولة البشر لتقديم أجوبة عقلانية لعدد من الأسئلة الجوهرية: كيف يتمكن الناس من العيش بطريقة أفضل، كيف يستطيعون الوصول إلى السعادة؟ وفي النهاية، كيف يبلغون الحياة المثالية؟

ما هي المعايير المقبولة لبلوغ السعادة والازدهار في حياتنا العصرية؟ هل يمكننا أن نعيش حياة أفضل بفضل الوفرة والعالم الافتراضي، والواقع المعزز، والخلود أيضاً؟ رغم أن الأمور لم تصل إلى هذا الحد بعد، إلا أنه يستلزم إعادة تحفيز الأخلاقيات حتى تكون إجابتنا على هذا السؤال "نعم بالتأكيد".

يَعدنا التطور المتزايد في الحوسبة، وعلم الجينات، والطباعة ثلاثية الأبعاد، والروبوتية، والذكاء الاصطناعي، بدفع البشرية إلى عصر غير مسبوق من الوفرة، مما سيساعدنا قريباً على توفير الحاجات الرئيسية وأكثر من ذلك لكل رجل، امرأة، وطفل على كوكبنا. ولكن لا يجب علينا أن نوكل مهمة اتخاذ القرارات الجذرية للتكنولوجيا والذكاء الاصطناعي فقط.

يجب علينا أن نساهم في تطوير البشرية المهددة. نستطيع، بل يجب علينا، التصدي للكسل الذي تسببه التكنولوجيا وأن نقلل من هيمنتها علينا. يجب علينا أن نضع قوانيناً جديدة لتنظيم حقول الابداع التكنولوجي.

حدثت تطورات مذهلة عبر الخمسين سنة الماضية في مجال التقدم العلمي، إلا أن بعض هذه التطورات أثارت تساؤلات مهمة فيما يتعلق بالمواضيع الأخلاقية والاجتماعية.

على سبيل المثال، أحدثت تقنية "كرسبر" الجديدة التي تسمح بإجراء تعديلات جينية محددة للبشر، والحيوانات، والنباتات، ثورة تعدّ الأكبر من نوعها في الهندسة الوراثية. فكر بالأمر.

يمكننا القيام بتغيير انتقائي للحمض النووي البشري.

مقارنة بما سبق من التقنيات، تعمل تقنية "كرسبر" بصورة أسرع وأسهل لتعديل الحمض النووي. تتألف "كرسبر" من عنصرين: الأول هو أنزيم يطلق عليه اسم Cas9 – ويتألف من "مقص جزيئي" لفصل الحمض النووي وقطعه إلى جزأين. أما الثاني، فهو RNA – "دليل جزيئي" بالغ الصغر يرشد أنزيم Cas9 إلى الجزء الذي يجب قطعه.

هنا تأتي التساؤلات والمخاوف الأخلاقية.

و.. بالفيديو: آخر صيحات التكنولوجيا قد تسرق وظائفكم!

لا زال أنزيم Cas9 إلى الآن عرضة للخطأ. فمن الممكن أن تنتج عنه تغييرات غير مرغوبة. ثم هناك احتمال تعمّد البعض بإحداث خلل ما. أياً كان الحال، تضطلع الأخلاقيات بدور رئيسي هنا.

يشكك المفكّر السياسي والاجتماعي يورغن هابرماس عن إمكانية الفلسفة الفوق فيزيائية من المساهمة بتوجيه أخلاقيات التعديل الجيني.

كخطوة أولى، يتوقع هابرماس إعادة النظر في مسألة تعديل الجينات الوراثية بناءً على التعداد البشري بصورة عامة، والجو السياسي العام وتأثير البرلمانات التمثيلية، ويرى أنه سيصبح مقبولاً أخلاقياً وقانونياً، في حال اقتصر الأمر على عدد من الحالات المحدودة من الأمراض الوراثية الخطيرة.

وفي الخطوة القادمة، يتوقع هابرماس أن يُصادق على التعديل الجيني من أجل الوقاية من الأمراض الوراثية؛ الأمر الذي سيقود بدوره إلى نقطة تتأرجح بين تحسين النسل السلبي والإيجابي مما يؤدي الى تحسين الجنس البشري بالتعديل الجيني.

إلى أي مدى نستطيع استخدام التكنولوجيا لإنتاج مخلوقات بشرية أفضل ومن يمتلك سلطة التحكم بنتائج هذه العملية؟ هل ستعتمد الدول حينها على مجتمعات من البشر تطوّر وتستخدم تكنولوجيا المستقبل لتنظيم حياتها في غياب المعايير الأخلاقية الجديدة أو المحدّثة؟

يجادل المؤمنون بتعزيز قدرات الإنسان اللامحدودة أن تكنولوجيا النانو، والتكنولوجيا الحيوية، وتكنولوجيا المعلومات، والعلوم الاستعرافية ينبغي أن تحسّن الطبيعة البشرية وغير البشرية. أما المشككين بالتكنولوجيا، فيعتقدون أن الممارسات التكنولوجية المتزايدة تسبب اضطرابات وتغييرات لا رجعة فيها. من الواضح أنه موضوع يقود إلى بعض المخاوف.

هل ستكون النتيجة إيجابية أم أننا سنواجه مستقبلاً مجهولاً مأهولاً بالروبوتات البشرية؟ هل نستطيع الحياة جنباً إلى جنب مع آلات أذكى وأسرع منا أم سنفقد انسانيتنا؟

الإنسان هو المخلوق الوحيد الذي يعرف أنه سيموت. كيف نتعامل إذن مع سعي البشرية الدؤوب لتحقيق الخلود؟

فكر بالمعنى الحقيقي للخلود. ستظل المعتقدات التي يتمسك بها أولئك الذين سيستطيعون هزيمة الموت في المستقبل هي نفس المعتقدات السائدة في كل عصر. فالموت حاصل لا محالة (لأسباب عنيفة، مثلاً)، إلا أن الخلود لن يعزّز التطوّر الاجتماعي أو يساعده، بل سيحدث ذلك ببطء. الحل الوحيد إذن هو إعادة البرمجة الجماعية.

ولكن نستطيع القول إن أصحاب النفوذ سيستطيعون التحكم بالبرمجة وليس بالأفراد المتأثرين بها.

نقطة أخرى يجدر ذكرها تتعلق بالأطراف الصناعية، والأدوية الذكية، ومعززات الدماغ التي تحسّن وظائف الجسم البشري أكثر؛ على الرغم من أن هذه الابتكارات تُحسّن حياتنا بطرق لا تُحصى، إلا أنها تثير العديد من التساؤلات الأخلاقية.

ما هي عواقب التدخل البشري بعملية التطور الطبيعي؟ هل علينا حماية البشرية من القوى التكنولوجية المنفّرة إن وجدت؟

ففي نهاية الأمر، لا نعرف ما الذي يمكن أن نخسره إذا تحكم البشر بالطبيعة. لا نستطيع أن نعرف إذا كان ما سنخسره قادر سيُحسّن صحة ورعاية الأجيال القادمة، أو أنه سيحد من حريتهم.

ولكن هناك القليل مما نعرفه-أمور نستطيع ويجب أن نتصرف بشأنها.

سيكون هذا العقد بلا شك الأكثر ريادة في تاريخ البشرية إذ تقود التكنولوجيا المتضاعفة إلى ابتكارات متزايدة. فيجدر بالأخلاقيات أن تواكب تطور التكنولوجيا غير المسبوق. وعلى الفلاسفة المعاصرين أن يستبقوا الأمور أكثر لتعزيز الأخلاقيات البشرية بطريقة تواكب التكنولوجيا.

علينا أن نسعى جاهدين للقيام بهذه الرحلة وعلينا أن ندرك المخاطر التي نواجهها. والأهم من ذلك، علينا أن نطالب بمناقشة التأثيرات الاجتماعية لهذه التقنيات إذا تركت بيد "صنّاعها" فقط.

يشار الى أن نحو 3000 من صناع القرار حول العالم سيناقشون هذا الموضوع وغيره من المواضيع الرئيسة في القمة العالمية للحكومات المقرر انعقادها في دبي في الفترة 8-10 فبراير 2016.